ChatGPT的核心功能

ChatGPT是由OpenAI开发的一款基于生成式人工智能(Generative AI)技术的对话式语言模型。它以海量文本数据为训练基础,能够理解人类自然语言的语义和语境,并生成连贯、逻辑清晰的回应。作为目前最具代表性的AI对话系统之一,ChatGPT的核心功能不仅限于简单的问答交互,还包括内容创作、逻辑推理、多轮对话延续等复杂任务,其设计目标是模拟人类的交流方式,提供接近自然对话的体验。

ChatGPT的技术基础:GPT系列模型演进

ChatGPT的底层技术源于OpenAI推出的GPT(Generative Pre-trained Transformer)系列模型。从早期的GPT-1、GPT-2到功能更强大的GPT-3、GPT-4,模型通过不断扩大参数量和优化训练数据,逐步提升了语言理解与生成能力。其中,Transformer架构的引入是关键突破——它通过“自注意力机制”让模型能够同时关注输入文本中的不同部分,从而更好地捕捉上下文关联,这也是ChatGPT能够进行长文本理解和多轮对话的技术核心。

ChatGPT的典型应用场景

凭借强大的语言处理能力,ChatGPT已在多个领域展现出实用价值,主要应用场景包括:

- 内容创作辅助:帮助用户生成文章、邮件、脚本、诗歌等文本内容,提升创作效率;

- 智能客户服务:替代传统客服系统,快速响应用户咨询,解决常见问题;

- 编程与学习工具:解释代码逻辑、调试程序错误,或作为语言学习、知识科普的互动助手;

- 创意与灵感激发:通过头脑风暴、场景模拟等方式,为设计、策划等工作提供新思路。

ChatGPT的优势与潜在局限

ChatGPT的显著优势在于其自然交互性和任务多样性——用户无需掌握复杂指令,通过日常语言即可引导模型完成任务,且支持跨领域的知识整合。然而,它也存在不可忽视的局限:例如,训练数据截止日期可能导致“时效性知识缺失”,偶尔会生成看似合理但与事实不符的“幻觉内容”,此外,对复杂逻辑推理和情感深层理解的能力仍有提升空间。

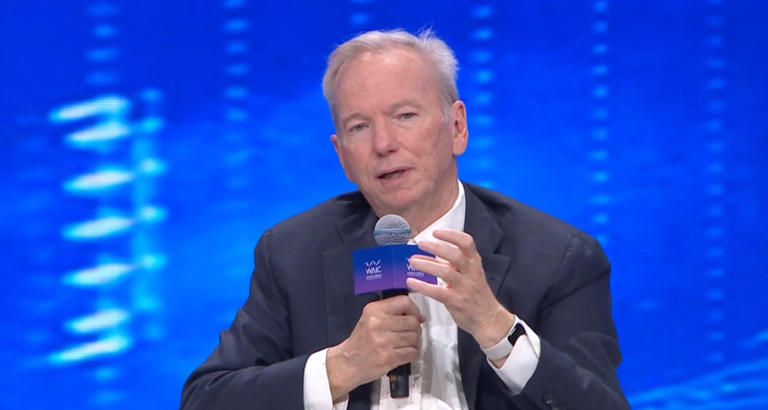

“AI模型的‘智能’本质是对数据规律的统计学习,而非真正的‘理解’。我们需要理性看待其能力边界,避免过度依赖。”——某AI伦理研究学者

ChatGPT的未来发展趋势

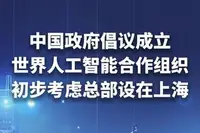

随着技术迭代,ChatGPT的发展方向逐渐清晰。一方面,多模态融合将成为重要趋势——未来的模型可能不仅处理文本,还能理解和生成图像、音频、视频等多种信息形式,实现更全面的交互体验。另一方面,个性化定制将进一步深化,通过学习用户习惯和需求,提供更贴合个体偏好的服务。此外,行业垂直领域的深度适配(如医疗、法律、教育等)也将推动ChatGPT从通用工具向专业助手转型。

评论 ( 0 )